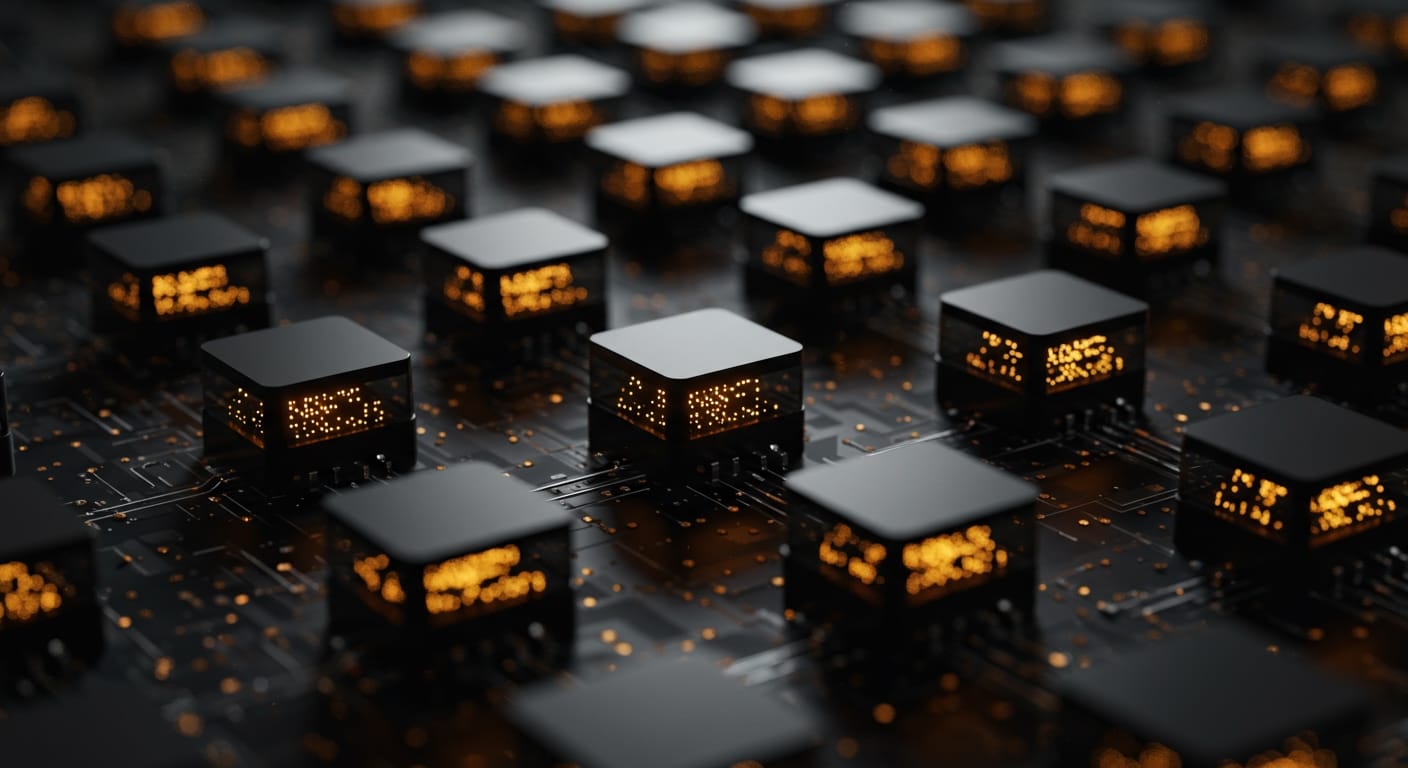

IA Agente: A Sinfonia de Caixas Pretas em Rede

Imagine um futuro não muito distante onde a inteligência artificial não apenas responde a comandos, mas toma a iniciativa, planeja e executa tarefas complexas com pouca ou nenhuma supervisão humana. Não estamos falando de um chatbot sofisticado, mas de sistemas inteiros de IA trabalhando de forma autônoma, cada um com sua missão específica, em uma dança complexa de algoritmos interconectados. Essa é a essência da Inteligência Artificial Agente, um avanço que promete revolucionar indústrias, mas que também nos confronta com um dos maiores desafios da era digital: a opacidade de suas decisões, o que chamamos de “problema da caixa preta”.

A Sinfonia de Algoritmos Autônomos

A IA Agente, ou Inteligência Artificial Agente, representa a próxima fronteira da autonomia digital. Diferente dos modelos de IA tradicionais que operam sob restrições predefinidas ou da IA Generativa que cria conteúdo a partir de padrões, a IA Agente se destaca pela sua capacidade de agir independentemente, estabelecendo metas e adaptando-se em tempo real para alcançá-las. Pense em um sistema de IA que, ao receber um objetivo final, como 'otimizar a cadeia de suprimentos', não espera por instruções passo a passo. Em vez disso, ele percebe dados, raciocina sobre eles, define sub-objetivos, toma decisões e executa ações autônomas, aprendendo e se adaptando continuamente.

Esses sistemas são compostos por múltiplos 'agentes' de IA, cada um focado em uma subtarefa específica. Um agente pode monitorar o clima global, outro analisar preços de combustível, um terceiro otimizar rotas de entrega, e todos se coordenam para alcançar o objetivo maior. Aplicações práticas já começam a surgir, desde bots de negociação financeira que analisam o mercado e executam transações sem intervenção, a sistemas em veículos autônomos que processam dados de sensores em tempo real para navegação, ou mesmo agentes de IA que automatizam partes do desenvolvimento de software ou do atendimento ao cliente.

A Névoa das "Caixas Pretas"

Contudo, a medida que a IA Agente ganha autonomia e complexidade, o antigo problema da 'caixa preta' se intensifica. O termo refere-se à dificuldade, até mesmo para os desenvolvedores, de entender como modelos avançados de IA, especialmente aqueles baseados em aprendizado profundo (deep learning) e redes neurais, chegam a uma determinada conclusão ou decisão. É como ter um carro que funciona perfeitamente, mas sem saber exatamente como seu motor toma cada micro-decisão para mover o veículo.

Essa opacidade levanta preocupações significativas. Se um sistema de IA Agente em um carro autônomo comete um erro, como podemos identificar a causa raiz se não compreendemos sua linha de raciocínio? Em contextos críticos como saúde ou justiça, onde a IA pode influenciar diagnósticos ou decisões legais, a falta de transparência impede a validação, a atribuição de responsabilidade e a correção de vieses que podem ser inerentes aos dados de treinamento. Modelos complexos podem perpetuar ou amplificar preconceitos existentes, e sem visibilidade interna, é quase impossível detectá-los ou corrigi-los.

Quando Caixas se Multiplicam: O Dilema Agente-Caixa

Com a IA Agente, não estamos lidando com uma única 'caixa preta', mas com 'muitas pequenas caixas pretas' interconectadas. Cada agente autônomo, enquanto trabalha em sua subtarefa, é em si uma caixa preta em miniatura, tomando decisões internas que são difíceis de rastrear. A coordenação entre esses agentes adiciona outra camada de complexidade e opacidade. Se o resultado final de um sistema multiagente é inesperado ou indesejado, identificar qual dos 'n' agentes, ou qual interação entre eles, foi a causa, torna-se um desafio hercúleo.

Essa arquitetura distribuída, embora poderosa pela sua capacidade de resolver problemas complexos em múltiplos passos, complica enormemente a auditabilidade e a segurança. A falta de clareza pode minar a confiança pública e dificultar a conformidade com regulamentações futuras que certamente exigirão maior explicabilidade dos sistemas de IA, especialmente em setores de alto risco.

Em Busca da Clareza: O Caminho para a IA Explicável

Para mitigar o problema da caixa preta em sistemas de IA Agente, a pesquisa e o desenvolvimento têm se voltado para a IA Explicável (XAI - Explainable AI). O objetivo da XAI é criar ferramentas e metodologias que permitam aos humanos entender o porquê de uma IA ter tomado uma determinada decisão. Isso pode envolver:

- Visualização: Gráficos e representações que mostram quais partes dos dados de entrada influenciaram mais uma decisão.

- Interpretabilidade inerente: Desenvolvimento de modelos de IA que, por sua própria arquitetura, são mais fáceis de entender, mesmo que sejam menos poderosos que os modelos de caixa preta completa.

- Auditorias de decisão: Ferramentas que permitem rastrear a sequência de decisões tomadas por um agente ou por um sistema multiagente, mesmo que o 'como' exato ainda seja opaco.

- Transparência de design: Documentação clara sobre a arquitetura do sistema, os dados de treinamento e as regras de orquestração entre os agentes.

A União Europeia, por exemplo, já está trabalhando em um arcabouço regulatório que classifica as aplicações de IA por risco, podendo restringir o uso de sistemas de 'caixa preta' em áreas de alto impacto como finanças e justiça criminal.

O Futuro Agente e a Responsabilidade Humana

A ascensão da IA Agente promete uma era de automação sem precedentes, onde máquinas não apenas executam, mas planejam e resolvem problemas de forma independente. No entanto, a complexidade inerente e a opacidade de suas 'pequenas caixas pretas' demandam uma abordagem cautelosa e proativa. A confiança na IA não virá apenas de sua capacidade de realizar tarefas, mas de nossa habilidade de compreendê-la, auditá-la e responsabilizá-la. O desafio é grande, mas a busca pela IA explicável é fundamental para garantir que esses sistemas poderosos sirvam à humanidade de forma ética e segura.

Leia Também